- Accueil

- Témoignages clients

- Segmentation et traçabilité des données - Atlanstat

Segmentation et traçabilité des données - Atlanstat

Témoignages clients • 05 mars 2021

La société ATLANSTAT a déployé la solution LockTransfer au sein de ses équipes afin de sécuriser le partage d’informations avec les laboratoires de son écosystème.

Un retour d’expérience d’Olivier Médard, responsable Informatique et Assurance Qualité, qui en profite pour nous donner des éclaircissements sur le fonctionnement des études cliniques dans le contexte de la COVID19.

Bonjour Olivier, pour commencer, pouvez-vous nous expliquer ce que fait ATLANSTAT et détailler votre périmètre d’activité ?

Historiquement, la société existe depuis 2002.

Nous sommes une CRO (Contract Research Organization), concrètement le pendant au niveau informatique d'une SSII, avec une offre de services complète en recherche et développement clinique à destination de l'industrie pharmaceutique humaine et vétérinaire, agro-alimentaire, des sociétés de Biotechnologie et de dispositifs médicaux.

En tant que sous-traitants ATLANSTAT va se positionner sur la phase de recherche avant l'homologation d'un produit ou d'un médicament et nous proposons des services de biostatistiques, de Data Management, de randomisation et d’opérations cliniques.

Les opérations cliniques permettent d’assurer la gestion des projets dans le respect des réglementations, la mise en place et le suivi des études dans les centres investigateurs (hôpitaux). Le data management permet d’assurer la collecte des données et leur vérification, les biostatistiques de les analyser.

On entend par exemple en ce moment des études sur les vaccins du COVID et ces études ont d'abord nécessité l'approbation d'une autorité.

Toutes ces activités se font selon un protocole qui a été approuvé par les autorités de santé.

Une fois l'approbation donnée, des investigateurs (principalement des médecins) sont recrutés. Ces derniers vont eux-mêmes proposer à certains de leurs patients ou à des volontaires de participer à tels ou tels protocoles.

La recherche clinique se décompose en plusieurs études et est généralement réalisée dans chaque phase :

Phase 1 : Tester le traitement sur des volontaires (petits groupes) qui ne sont généralement pas porteur de la pathologie. L’objectif de ces études est d’évaluer sa toxicité (tous les traitements ont des effets secondaires) et de préciser la posologie à appliquer en phase 2.

Phase 2 (étude de l’efficacité) : Périmètre plus large avec des volontaires atteints par la pathologie. L’objectif est de déterminer la dose minimale efficace du médicament et ses effets indésirables donc de trouver la dose présentant le meilleur rapport efficacité/risque.

Phase 3 : La phase 3 est la dernière étape avant une mise sur le marché. Le nombre de volontaire participants à ses études est encore plus important (de centaines à des milliers de personnes en fonction de la pathologie). Ces études permettent de s’assurer de l’efficacité du médicament ou du produit. Pendant ces études, le médicament ou le produit est souvent comparé au produit/médicament de référence pour savoir s’il apporte un bénéfice supplémentaire (plus d’efficacité ou moins d’effet secondaire, ou les deux ce qui est le cas le plus favorable). Si le résultat est favorable, le médicament bénéficie d’une AMM (Autorisation de Mise sur le Marché) et peut donc être commercialisé.

En fonction de la phase de développement, de notre implication dans l'étude, la gestion du projet sera plus ou moins complexe au vu de la quantité de données à gérer.

Sur des études de phase 3 par exemple, qui implique souvent plusieurs pays/continents, la gestion des études sera donc beaucoup plus lourde que sur les études de phase 1.

En interne nous allons avoir des chefs de projets cliniques pour gérer les opérations cliniques, des profils Data Manager pour gérer les données et des biostatisticiens pour analyser les résultats.

Un des principes de base est la traçabilité : Toute donnée qui rentre chez ATLANSTAT doit sortir sous la même forme de nos systèmes et s'il y a eu modification de données, nous devons être capables de prouver pourquoi la donnée a changé et qui a fait cette action. Nous ne pouvons changer nous-même une donnée, le changement doit être réalisé par l’investigateur et nous mettons à sa disposition les outils permettant de le faire en respectant la traçabilité requise.

Opérationnellement, nous avons d’autres services en lien étroit avec le Data Management c'est le service de randomisation : avant de commencer une étude, les essais sont randomisés.

Concrètement, l’étude mise en place va proposer plusieurs traitements : celui qui est en test et des placebos ou d’autres produits existants. Les volontaires se voient attribuer l’un des traitements « au hasard ». Ce hasard est généré informatiquement, le patient et/ou l’investigateur ne sait pas quel est le traitement administré. Par exemple, il n’est pas donc possible de donner le traitement « test » à tous les sujets qui semblent les moins atteints et le produit de la concurrence aux plus atteints ou aux plus âgés. Cela évite les biais lors de l’analyse statistique.

Nous avons enfin des services de support comme le Service Informatique et d’Assurance Qualité dont je m'occupe.

Le travail du service informatique va être notamment de s'assurer que les applications utilisées sont validées et répondent au règlement des bonnes pratiques cliniques qui est un référentiel que l'on doit suivre.

Concrètement, nous devons nous assurer que les applications garantissent un haut niveau de traçabilité, comme expliqué tout à l'heure, mais nous devons également maintenir nos procédures qualité qui sont nombreuses. Nous avons, pour exemple, à peu près 150 documents qualité pour une société de 27 personnes.

Par rapport au secteur de la recherche clinique, existe-t-il des problématiques de sécurité de la donnée spécifique ?

Déjà nous gérons des données sensibles et puis ensuite nous revenons sur des problématiques de qualité et de satisfaction client. Nous ne perdons jamais de vue, qu’au final, nous devons tout mettre en œuvre pour garantir la sécurité du patient, qui sera vous ou moi demain.

En effet, ATLANSTAT doit apporter la preuve que la réglementation qui s'impose à nous est respectée (procédures, validation, ...).

Nous devons nous assurer que les données sont intègres donc il y a un vrai besoin d'intégrité. Dans tous les départements cités précédemment, il y a vraiment une problématique importante sur l'accès et la protection des données et c'est cela qui est peut-être spécifique par rapport à d'autres secteurs.

Toute l'industrie pharmaceutique doit respecter les Bonnes Pratiques Cliniques, ainsi que les différentes lois et règlements français et européens relatifs à la recherche clinique et à la gestion des données. Nous sommes souvent audités, par nos clients notamment, par rapport à cette réglementation-là.

Nous devons donc être capable de prouver que la donnée a été collectée à telle date, dans un format de fichier lisible, que l'accès aux données est bien protégé et que la personne qui a signé a bien reçu le document.

C’est finalement le "Qui a accès à quoi" : Par exemple un statisticien va générer des résultats à partir d'une base de données fournies par le Data Management et le Data Management n'a pas le droit de voir les résultats, les statisticiens n’ont pas la possibilité de modifier les données fournies par le Data Management.

Donc il y a un vrai cloisonnement même en interne finalement ?

Tout à fait. Le principe, que l'on retrouve d'ailleurs dans le RGPD, c'est l'anonymisation générale de tous les process. Toutes les données sont anonymisées avant de rentrer dans nos systèmes d’informations, ATLANSTAT n’a jamais de données nominatives. Une fois dans nos systèmes, l’accès aux données est géré selon les profils et les personnes dédiées au projet. Il y a une minimisation des accès et donc des risques à chaque étape du développement du projet.

Si on revient sur LockTransfer maintenant : Quelle(s) population(s) sont concernée(s) ? Pour quel cas d'usages ?

Ce qui est important chez ATLANSTAT c'est la donnée donc les utilisateurs de LockTransfer sont ceux qui gèrent la donnée : les équipes Data Management et Statistiques.

Sur une étude en cours, les data manager vont faire régulièrement des rapports qu'ils envoient à leurs clients afin qu'ils soient au courant de l'avancée de l'étude (par exemple : combien y a-t-il de patients inclus dans l'étude).

De manière générale, les laboratoires qui obtiennent une AMM rapidement, seront ceux qui rentabiliseront le plus rapidement leurs investissements, donc c'est très important pour eux de suivre le planning, d'où la nécessité de ces rapports.

Concernant l'écosystème, nous allons, en tant que sous-traitant, envoyer nos travaux, nos données aux équipes Data Management des laboratoires avec lesquels nous travaillions.

En fonction des informations transmises, nous partageons aussi des documents avec leurs chefs de projet.

Ensuite sur le type de documents, nous avons à partager des listings Excel, des fichiers de tracking, des documents de validations, des bases de données (pour des échanges entre le Data Management et les statisticiens) ou encore les résultats d’analyse statistique.

Dernier point, nous n'utilisons pas LockTransfer pour des échanges internes mais uniquement pour des partages externes.

Dans votre utilisation de LockTransfer, êtes-vous également sur une approche bidirectionnelle ?

Cela va dépendre des projets. Sur des gros projets nous allons plutôt être sur du bidirectionnel. Et sur des petits projets plutôt de l'unidirectionnel.

Il n'y a pas vraiment de règles en réalité : nous utilisons le plugin Outlook, les transferts classiques mais également les espaces d'échanges sécurisés.

Il arrive aussi que les laboratoires nous fassent parvenir des documents via leurs propres solutions.

Ces process là sont définis au début du projet.

Quel est maintenant, selon vous, le point clé sur un outil comme LockTransfer ?

Deux points importants selon moi :

- Sécurité avec ma casquette IT et AQ (Assurance Qualité)

- Fiabilité sur la partie opérationnelle. Si ça ne fonctionne pas quand les équipes en ont besoin c'est problématique.

La qualité de l'interface graphique passe au second plan par exemple.

Si vous deviez citer une amélioration à apporter à l’outil, quelle serait-elle ?

La fonctionnalité attendue c'est l'automatisation, le chargement et l'envoi automatique de documents via l'utilisation d'API (ndlr : fonctionnalité désormais disponible).

Sur la partie Data Management, les collaborateurs génèrent des rapports dont la fréquence est définie avec le client.

Il y a des études qui durent 15 jours et d'autres 8 ans donc si pendant 8 ans une personne doit aller charger dans l'interface un fichier et envoyer le lien, il va attendre impatiemment le fait de pouvoir automatiser ces tâches-là.

Tous les process d'extraction, de génération de rapports sont automatisés et il ne manque plus que l'automatisation de l'envoi des résultats.

C'est d'autant plus important que, même si nous travaillions principalement avec des organisations en France, certains clients sont à l'étranger. Sans automatisation, nous pouvons perdre jusqu’à une demi-journée à cause du décalage horaire.

L’automatisation permettra donc de fluidifier les projets et surtout permettra au Data manager de se focus entièrement sur leur cœur de métier.

Merci Olivier !

Vous travailliez dans le secteur de la santé ? Plus d'informations et cas d'usages ici.

À lire aussi

Articles recommandés pour booster votre cybersécurité

Témoignages clients

DeepTech : la nécessaire souveraineté des données sensibles

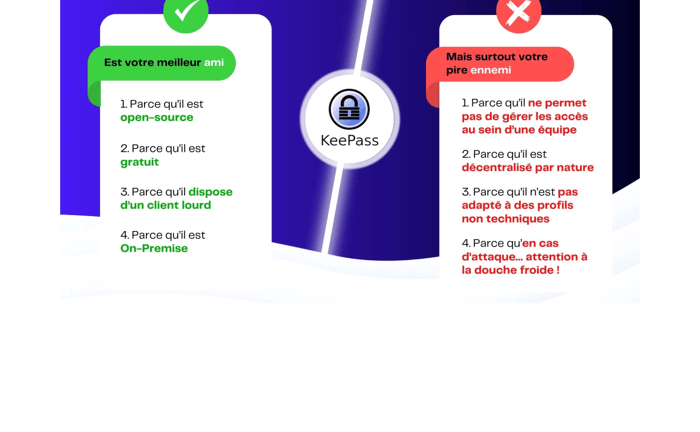

Coffre-fort de mots de passe

KeePass : un faux ami dont vous devez vous séparer !

.png?width=700&name=Related%20content%20-%20Clusif%20(1).png)

Témoignages clients

Sécurité des mots de passe : le CLUSIF a choisi LockPass

La cyber missive

Tout savoir sur l'actualité cyber en France

Directement dans votre boîte mailChaque 1er jeudi du mois

Sommaire

Segmentation et traçabilité des données - Atlanstat